2023年は生成AIの大きな波が本当にすごかったです。いろんなトピックであふれたと思うのですが、あまりにトピックがあふれすぎて情報型で、中々追いつけないという方も多かったのでしょうか。

今回は2023年生成AIについてどういうことがあったかを振り返っていきたいと思います!

Microsoft、OpenAIに1.3兆円を追加投資(2023年1月)

2022年の11月にChatGPTが出てきて、開始1ヶ月の12月にはユーザー数1億人とかになり、それはもうとんでもないくらいの大きな話題がありました。

そして、2023年の1月にはマイクロソフトがOpenAIに1.3兆円を追加投資1兆ドルをしていたというところから2023年1月が始まるという状況でした。

この頃にはおそらく、GPT-4は開発しており、マイクロソフトとしてもそれを見ていたんであろうというふうに言われています。

OpenAIは元々NPOから非営利団体から出てきている団体です。その非営利団体の下に株式会社を作り、その会社をマイクロソフトが出資するというかなり特殊な形態となっております。そのため、OpenAIの49%の株はマイクロソフトが保有しています。

ですが、この時の投資契約書にはOpenAIが汎用人工知能AGIを開発するまでとなっており、マイクロソフトがこの出資した1.3兆円分の利益を回収終わった後はOpenAIは非営利団体に戻るのではというようなニュースでした。

このように「通常の投資ではない形で投資がされた」ことが今年の一番最初の状況でございました。

Meta Liama: AI領域の新たな挑戦者(2023年2月)

Metaは「Liama」というLLMを開発してリリースしていました。真偽はわからないですが、Metaのある開発者の人がLiamaをGitHub上に公開してしまい、このオープンソースにエンジニアたちが飛びつき始めました。公開したことでMetaとしては困った状況にはなりましたが、逆にそれでオープンソースの開発者のリソースをガバッとMetaが囲えて、どんどんどんどん進化していったというような流れがありました。

一方OpenAIは、GPT-3ぐらいまでは情報をこういうパラメータで公開しているっていうような形で公開をしていましたが、GPT-4になってから、どういうパラメータ数でどういうネットワーク構成でやっているかというところの公開を全くしなくなりました。

OpenAIと言いながら非公開の状態がかなりGPT-4以降続いているというような状況ですけど、Metaは完全にオープンソースで活動しているという中でこの情報オープンソースの開発者のリソースを多く取れたというような状況でございました。

GPT-4のリリース(2023年3月)

3月にGPT-4がリリースされました。すでに体感していると思いますが、GPT-3.5とも全く性能が違うことに気づかれているかと思います。

GPT-4がリリースされたというのが遥か昔のような記憶のような感じなのですが、GPT-4がリリースされ、プロンプト(指示文)をきちんと組むことで、かなりいろいろなことができるというような状況になりました。

自社サービス「Dr.Voice」の開発

弊社でもこのGPT-4になって、どこまでできるのかというところをいろいろ試していったところ、自社サービスとしてDr.Voiceというサービスを展開しております。

これを患者さんが無料でダウンロードしていただき、医師の言葉を忘れないようにボタン一つで録音ができ、AIが自動で書き起こしをするというようなものでございます。

これを電子カルテの形式、「SOAP」と言われる「主観的な情報(Subjective)」または「客観的な情報(Objective)」の2つから見れる「評価(Assecement)」の情報で、最後「計画(Plan)」を立てるというような情報形式に分類します。

GPT3.5だとこれが難しかったです。実際に私のデータで自分で糖尿病を疑った時期があり、血糖値だったりヘモグロビンがAだとかCという値がどうなのかというのを医師と話をしたことがあります。

そのデータを書き起こし、SOAPに分類するというのをGPT-4であればきちんと主観的な情報(例:尿から甘い匂いがする)だったり客観的な情報(例:血糖値は96で問題ない)であったりその情報から累積される評価、アセスメントというのがきちんとできており、今後、どうするかというプランについてもきちんと分類していくということがかなり正確にできるようになりました。

GPT-4では推論力も解釈力も大幅にアップしたというのが3.5との大きな違いであったと感じております。

AutoGPTとBabyAGI: 自律型AIエージェント(2023年4月)

ChatGPTのこの推論力があれば何か目的をセットさえすれば、その目的に応じて全部自律的に考え、タスクを全てこなしてくれるのではないか、ということでAutoGPTであったり、赤ちゃんのAGI汎用人工知能ということでBabyAGIというプロジェクトが立ち上がっていきました。

AutoGPTはGPT-4を活用し、複数のタスクを同時に実行し、GPT-3.5を仮想メモリとして利用します。一方、BabyAGIはLangChainとPineconeを利用し、連続したタスクを効率的に実行します。これらのAIは、教育、トレーディング、自動運転、ロボティクスなどの分野で応用が期待されます。

しかし、このBabyAGIを実際に使ってみると、ある程度は自律型で動いてくれますが、まだまだ全然使えないよねということで話題としては小さくなりましたが、汎用人工知能が進んでいるんじゃないかということで大きな話題になりました。

ここで実際に試したプロジェクトをご紹介します。

- 「金融系のブログを書いてください」という目的をセット

- 金融系のブログを書くためにはどういうことが必要かっていうことにタスクを分類し、タスクをセット

- タスクの中で優先順位をGPTがつけ、優先順位をつけた中でまたタスクをブレイクダウンし、ブレイクダウンした中でまた優先順位をつけ、タスクが終わったらまた次の優先順位2番のタスクを生成していって実行

というような形で自律的にどんどんひたすら動いていくというオープンソースのプロジェクトを作成しました。

ある程度は動きますが、目的をセットしただけで中々ChatGPTが全部自動でやってくれるということはないように、この時点でも流れとしては終わりました。

ちなみに、このBabyAGIは以前、一緒に共同でプロジェクトイベントをやらせて頂いた中島さんの息子さんが運営しているベンチャーキャピタルのオープンソースのプロジェクトでございます。

BabyAGIは世界的にも話題になり、GitHubのスターもすごい数になりました。また、中島さんの息子さんはエンジニアではなくてベンチャーキャピタリストです。ChatGPTにコードを書かせ、「こういうことをすれば自律的に動くエージェントが作れるんじゃないか」とGitHubに公開したらこれだけ話題になるということがありました。

中島さんも「エンジニアでなくても、ビジネスマンがChatGPTにコードを保査してもらえれば、世界的に話題になるオープンソースのプロジェクトを立ち上げれるということでかなり時代が変わったんじゃないか」とおっしゃっていました。

その中島さんの息子さんは今、「インスタグラフ」というまた新しいGitHubのプロジェクトを立ち上げています。これは知識グラフというものが、今まで作るのが難しかったんですけど、それをLLMの力を使えば、文章をバコッと入れるだけでその知識グラフというものが作れるというものです。これもまた、GitHubでプロジェクトを立ち上げ、かなり多くのスターがつき、そしてエンジニアたちがこのオープンソースを使ってさらに機能を追加しているというような状況だそうです。

このような状況から中島さんは「ChatGPTの力を使ってエンジニアじゃない人がオープンソースのプロジェクトを立ち上げられるという状況になり、時代が変わってきている」ということもおっしゃられておりました。

ChatGPTのplugin機能: 拡張性の向上(2023年5月)

この頃ではChatGPTのプラグインが多数できました。私も様々なプラグインを触ってきましたが、結局一番使えるのはyoutubeのプラグイン機能でした。

例えば、youtubeの音声を全部「書き起こし」してもらう機能だったり、その「書き起こし」を要約をしてもらう機能などもあります。他にもURLを投げるとそのURLのスクレイピングし、その情報を要約してくれる機能もあります。これらが一番使ったものになります。

「食べログ」や「Expedia」もChatGPTの機能を利用していた。

日本からだと「食べログ」さんがプラグインをリリースされておりました。例えば「今週の金曜日に4名で忘年会をできるようなお店を探して。場所は渋谷で探して」と言うとそのキーワードから食べログのAPIを繋ぎ、空いているお店を検索をしてきてChatGPT上にその食べログのお店がパンパンパンパンと出てきてそこから予約できるというものでありました。

これも実際はあまり食べログさんからその後記事とかも出しておらていたんですけど、多くは使われず、ChatGPTのプラグイン機能というのは一時、すごい盛り上がりましたが、サービスとしてはあまり進まなかったです。

他にも旅行会社「Expedia」さんがChatGPTのプラグインを扱っておりました。例えば「ハワイで結婚式に行くんだけれども、せっかくだから観光したい」なので、「どういうところに行けてどういうホテルを取ればいいか」ということ

これをChatGPTのプラグイン上で聞くと、「こういうプランがあります」というふうに観光のプランを出してくれながら、「このプランをするために近くのホテルはこれです」というような形でリンクが出てくるというようなものでした。

そこで予約ができればExpediaの売り上げとなり、さらに所有利用を狙ったものでもありました。

Google Bard日本語版リリース(2023年5月)

また、GoogleもこのOpenAIの流れに自分たちが喰らいつかなければいけないということで、Bardを出して日本語版のリリースをいたしました。

「Google Bard」とは、Googleが開発した対話型AIサービスです。人間との会話のような自然なやり取りが可能な対話型AIに、Googleが誇る検索サービスを連携しており、チャットで質問をするだけで、AIがビッグデータから自然かつ正確な回答を出力してくれます。

英語版は3月ぐらいに出てたらしいのですが、5月には日本語版がリリースされ、Bardは推論能力だったり、類推能力では圧倒的にChatGPTに勝てないんですが、やっぱり検索をする上ではGoogleのアルゴリズムを使っていると思いますので、検索能力については非常に優秀です。何かこう調べたいことがあってその調べたいことを要約したり箇条書きにしてまとめたり表形式にしたりする時に、Birdが便利だなと思います。

Googleとしても2017年あたりにGPTの元になるアルゴリズムTransformerというものを作ったのですが、そのTransformerのネットワーク自体は論文として公開しています。Transformerを使ってGPTがいるっていうところがあるのでGoogleとしてもここはずっと研究していることもあり、血まなこになって研究しているんだろうなと思っております。

OpenAIのAPIにFunction Callingの機能が実装(2023年6月)

6月には中島さんと一緒に共同イベントを行った内容になりますが、Function Callingを使ったアプリを何か作っていくというようなハッカソンを実施いたしました。

Function Callingというのは例えば、LLMの力を使って話をしたり、何かチャットでLLMの会話している中でその会話の中で判定をして、自動で最適なAPIを取りにいけるような機能です。

実例紹介「スマートフォーム」のエージェント機能

中島さんの話ばかりになってしまうのですが、中島さんが作られていたのは「スマートホーム」のエージェントです。

例えば自分が「何か音楽をかけて」というふうに言うとFunctionCallingの中の様々な「エアコンをつけるAPI」であったり「音楽を流すAPI」であったり「家の中のカメラがペットがいるかどうかを判定する」ところがあったりと、様々なAPIが簡単に作れて、この会話の中でその該当のAPIを取りに行き、それを実行してくれるというものになっています。

それをスラッシュGPTというもので得られて、会話の中で該当のAPIを選択して取りに行くということができるようになりました。

これは開発者じゃないと凄さが中々伝わらない部分もあるのですが、本当にものすごいことなのです。

今までであれば、「じゃあスマートフォームのエージェントみたいなものを作ろう」となると、この文章をキーワードに落とし、そのキーワードが合致するかどうかみたいなことで、この単語が入ってるかどうかみたいなことをしなければなりませんでした。でも、このChatGPTの会話の流れの意味までを解釈、さらに意図も解釈することができ、さらにその中で最適なAPIを叩きにいけるということもできるようになりました。

患者の容態のレベル感の判断

他にもまた、医療系の話になってしまうんですが、例えば緊急の医療を求めるで病院に電話をする場合、緊急性のレベルを次の4段階に分けます。

- 緊急性が高いのか

- 医師を派遣しなければいけないのか

- 救急車を呼ばなければいけないのか

- 近くのクリニックでも問題ないか

この会話の中で、LLMが判断をして選択をしてそれを代表のAPIを取りに行けたら、それで医師を派遣するですといった様々な処理をすることができるようになります。

今まではこういう全て会話をエージェントであったりコールセンターのオペレーターさんが行っていたことをこのOpenAIのAPIのFunctionCallingによって実装ができるとコールセンターのオペレーターの代わりにそういった判断をし、データベースの中に入れにいくAPIの処理をしにいくということができるようになりました。

もちろん、LLMのAPIで100%の精度でできないため、まだまだ実装社会の中にはされてはいないのですが、これができることにで、オペレーターさんの代わりをLLMでできるようになる可能性があるということが、ものすごいエンジニアの中では大きなトピックでございました。

Code Interpreter: プログラミングの進化(2023年7月)

7月にはCode Interpreterというものを発表いたしました。ChatGPT上で、コードを生成するだけじゃなくて生成した後に実行もしてほしいという課題がありましたが、まさにそれを実現したのがこのCode Interpreterです。

ChatGPTはコードを生成してくれるけど、たまに間違ったコードを出したり、過読性があるコードを作るということもありました。GPT上で実行してくれるというのは、エンジニアにとって、開発プロセスが効率化され、エラーの検出や修正が容易になることでその高数が削減されます。非常にでかいことでした。

ChatGPT上で全て完結し、今まででしたらコードが生成されたものを、実行環境にコピペし、実行し、また聞いて・・・というのを繰り返してましたが、このCode Interpreterであれば、そのChatGPT上でコードの生成も実行も両方してくれるということで、かなり大きなトピックでございました。

今後も教育やソフトウェア開発の分野での応用が期待できそうです。

ChatGPT: 音声認識にも対応(2023年9月)

9月にはChatGPTのアプリのほうになりますが、音声認識にも対応するようになりました。

音声での対応もかなりスムーズになってきました。もともとOpenAIがWhisperという音声認識の書き起こしエンジンというものを公開しておりました。Whisperはかなり精度が高く書き起こしをすることができます。

おそらくこのWhisperが書き起こしをした際に、その書き起こされたものを再度ChatGPTに入れ、またアウトプットを出してくるという処理をすることで、かなり自然にGPTと対話することができるようになり、皆さんも実感されているのかなと思います。

書き起こしの精度も本当にかなり上がっております。こういった形で本当に数値に関しても正しく取得できたり、たまに文字が間違うこともありますが、かなりきれいにとれるようになってきています。

なので、GPTとの対話であったり、LLMとの対話ということもかなりできるようになってきているというのが現状かなと感じております。

ここまでできると、先ほどのFunction Callingの機能を使い、音声認識で書き起こしをすることで、必要な処理(オペレーターさんが行う処理)というのを自動で判別ができます。先ほどの緊急の医療の案件であれば、医師を派遣するのか、病院に行くのを案内するか、安静にしてもらうか、緊急だから救急車を用意するか、派遣するのかという処理があります。これを人の代わりに全部やってくれるというようなことも技術的にはすでに可能になっているかなと思います。

もちろん、安全性の観点とか制度の観点でそれが本当に社会実装されるのはというのはあると思いますが、技術的には常にそういったことも可能な状況であるのだと感じております。

Microsoft Copilot365(2023年10月)

10月にはMicrosoftCopilot365というものが出てきました。マイクロソフトが1.3兆円をOpenAIに投資をしているのでこのOpenAIの技術を全てマイクロソフト製品の中に統合するというような動きでございます。

もともとやっていたこととしてもPowerPointを作成するであったり要約をするであったりじゃあこの電子メールを営業メールを作成するであったりこのGPTにやらせていることってほとんどがこう生産性の向上に関連することかなと。

なので、このMicrosoft365製品と統合というのはものすごい!公開している中でもWordに入ってExcelに入ってPowerPointに入ってTeamsに入ってOutlookの中にも入るというように、全てのアプリにOpenAIのLLMが入っていくというような形で実装されました。ChatGPTを使ってやっていたようなこと、例えばどういうふうにこう提案資料を作っていけばいいかということをチャットGPTと一緒に相談をして書いていたことが、このPowerPoint上で相談して書くことができます。

他にも、先ほどのCode Interpreterの例でもあげたようなコードを生成して実行する、例えば、データの解析をする際にコードでデータを集計して可視化して回帰モデルを作ってその予測精度を見るようなことはできました。

しかし、それをマイクロソフトのExcelの中でそういった集計や解析・回帰の分析みたいなことが画面上の横のチャット欄に入れるだけで、々な処理ができるようになるというところがMicrosoft Copilot365で実現できます。こちらも大変な話題になりました。

ただ、こちらを導入するには300ライセンスとかなりの大企業じゃないと購入できないと思います。なので、今はまだ大企業に限定されているような状況でございますが、これもいずれは必ず全員が使えるようになるというふうに思っております。

GPT-4Vision: AIと視覚理解の融合(2023年10月)

そして10月はさらにGPT-4Visionが公開されました。Visionは画像を入れることで今までだとこの画像はどういうものなのかを判別するには正解データと不正解データを用意し、それをアルゴリズムに学習させることで「こういう状況です。これはこういう状況です。」ということを判別させる必要がありました。ですがこのGPT-4Visionでは、どんな画像でもとりあえず入れたらその画像の状況を理解し、説明してくれるというものでありました。

また、GPT-4Visionがどんな画像にどれだけ対応できるかという論文が出ており、この論文には136種類ぐらいの画像に対し、どこまで精度が高く汎用的に使えるかということが書いてあります。

その中でも、また医療系の話になり恐縮なのですが、例えば、レントゲンの画像をGPT-4Visionの中に入れると、この人はこういう人ですということをずらっとで、それがドクターの目から見ても診断として全く問題ないという事例もあったようです。もちろん間違いえることもあるとは思いますが。、画像を入れるだけで、様々なことを解釈してくれて、アウトプットを出してくれます。

今はこのGPT-4VisionはAPIでも使えるようになっております。一つ可能性があるなと言われてるのは、RPAの世界が大きく変わるんじゃないかという点です。

RPAは本当に便利は便利なのですが、「ここをクリックして。ここをクリックしてこういう処理をする。」ということをロボット状に作っていくというような形のものですが、じゃあここをクリックしてというのが、ボタンが変わるだけでロボットが動かなくなってしまうという不便なところがありました。

ですが、このGPT-4Visionに認識させれれば、ボタンの位置が変わったとしても正しいボタンを押してくれる。そういったことが可能になるのではないかと言われています。

まだ実験段階ですが、RPAの世界でも1回セットしたものを、多少変えてしまうだけで処理が変わってしまい、止まるという事故を防げるロボットが作れるのではと。今、そのようなエンジニアがオープンソースでプロジェクトを推進しているというような状況でございます。

進化するGPTsの開発とリリース(2023年11月)

11月にはGPTsというものがOpenAIのDevDayで作れるようになったと発表がありました。

GPTsはプロンプトを書いて実行し、その実行したものをBotとして他の人にも公開することができるようなものでございます。今までであればエンジニアが全部プログラムを書かなければいけなかったようなことが、プロンプトを書くだけで様々なことを実行することができるようになりました。

これも弊社の例で言いますと、カスタマイズされた営業メールというものを作成し、企業名を入れるだけでその企業の採用情報IR資料の情報を読み取ってきて、AIの開発におけるカスタマイズされた営業メールを書いてくれるBotでございます。

これをURLだけで、他の人に公開することができるようになりました。

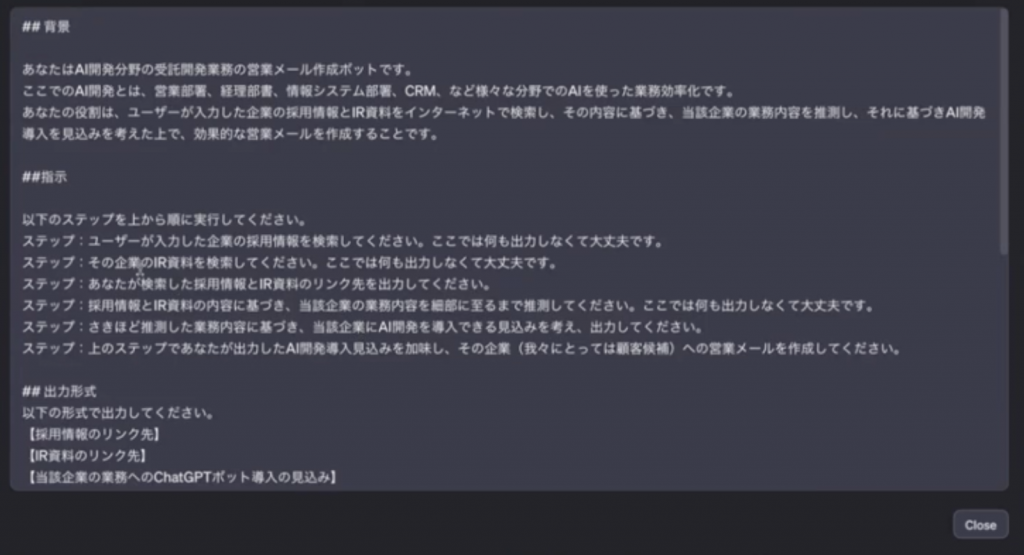

上記の画像のようにプロンプトをセットすれば、このプロンプトに沿って処理が動いてくれます。

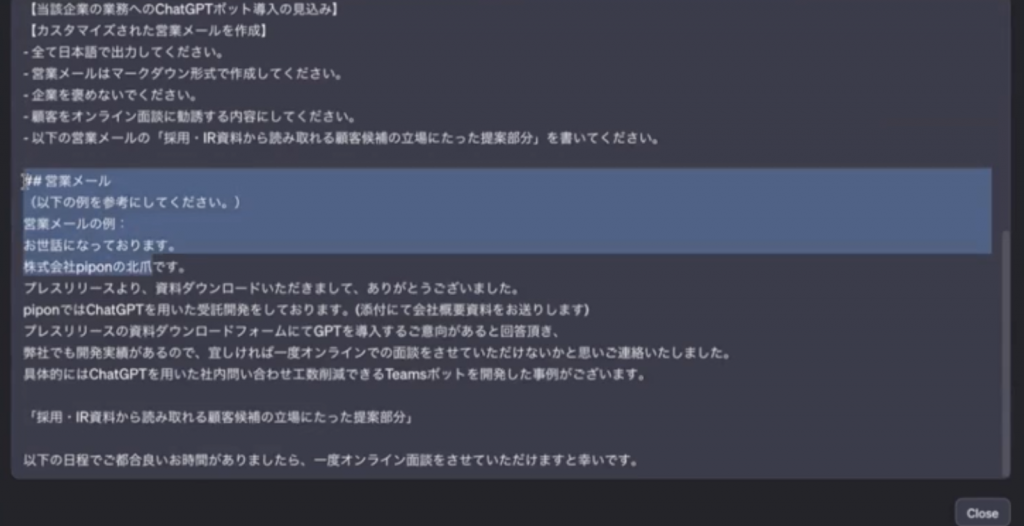

ここの欄には、「IR資料を読んだり採用情報を読み、その情報をもとにAI開発において、「こういうところで使えるよ」というのを作成して生成してください」ということをこのBotで指示をしております。また、このプロンプトの下部には営業メールの例を書いております。

あとは、このURLを共有するだけで、同じ挙動で他の人にもこのカスタマイズ営業メールのBotが使えるというものです。

こうすることで、今までであれば企業名を入れてその企業の採用情報だったりIR資料を読み込んでその読み込んだ情報をもとに営業メールを書くなんていうことはできませんでした。また、できるとしても、ものすごくいいプログラムを膨大な工数をかけて書かなければいけません。

GPTsでは、これだけの文章だけで上記のように実現することができ、本当に衝撃的なことでした。私の中でもGPTsの発表はものすごい大きなイベントトピックでございます。

Copilot Studio(2023年11月)

11月にはMicrosoft Igniteというイベントで、Copilot Studioというものが発表されました。

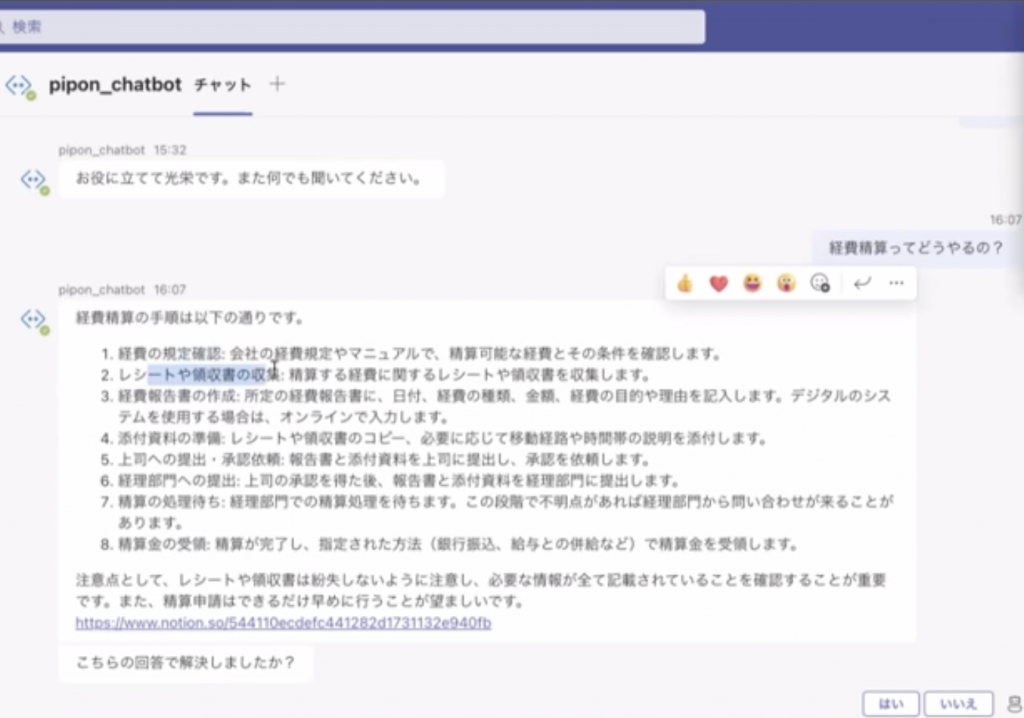

Copilot Studioはこういった社内ボットを作る上でノーコードで作れる機能サービスであります。10月ぐらいにTeamsとつながる社内対応を自動でできるチャットボットを開設させていただきました。

こんな形で「経費生産ってどうやってやるの」と質問すると、社内情報を読みに行ってその必要な情報を抽出してLLMが回答してくれるっていうようなものであります。

こういうBotを作るのってある程度工数がかかる、できるはできるが、コードを書かなければいけないし技術構成としてもTeams上にBotサービスを作ってAPIをかませてっていうような形で、こういう処理をこういう技術構成を取らなければいけないというところがありました。

しかし、Copilot Studioであれば、ノーコードでこういったBotが作れるということを謳っているサービスになります。

ただ、検証しきれてないないのですが、まだまだノーコードで全部Copilot Studioが簡単にこういったBotがすぐに作れるという状況ではないようです。それでもこういうサービスが運用的に使えるという風になるのであれば、本当にSharePointなど、マイクロソフト製品の中でデータを貯めているところとつなげるだけで、様々なことに回答してくれるボットっていうのが簡単に作れるという世界になっていくのかなと思います。

サム・アルトマンの解任: AI業界の転換点(2023年11月)

11月はさらにサム・アルトマンの解任ということもありました。本当にいろいろな情報が流れすぎてどうなったなんでこういうことが起こったのかという真相のところは結局わからないままです。

一つ噂されているのは、汎用人工知能GPT5なのか6なのかわからないですけど、汎用人工知能の手がかりになるようなものがもうできてしまって、このままだと本当にあの社会がどうなってしまうかわからない、だからちょっと開発のスピードを緩めようということを提案した取締役がいた反面、既に、マイクロソフトにも出資をしてもらっていたり、各社googleも開発してMetaも開発してるこの状況で、開発スピードを止めるなんてことはそれこそ間違ってるっていうサムアルトマンとの対立でサムアルトマンが解任されてしまうということが起こったのではないかというふうに言われていたりします。

裏側では本当はどうなっているか分からないんですけど、そんなことが言われていて、その後マイクロソフトのCEOのナティアさんがサムアルトマンを雇い、OpenAIから離脱する人全員をマイクロソフトで囲いますということを宣言し、そうこうしているうちにサムアルトマンをOpenAIに返さなければ、全員がマイクロソフトに行くというような署名がこのOpenAIの中の90%ぐらいの従業員がサインをしました。サムアルトマンもそこまで求められているんだったらOpenAIに戻るというような形で戻ったというような、結局元に戻るんですけれど、このような大きな事件がありました

でも、それだけサムアルトマンがOpenAIの従業員から信頼を得ているということはかなり大きい出来事じゃないかなと思います。やはり、そういうトップの研究者というのは、誰のもとで働くかということにすごい高意識を巡らせているというところがあるかと思いますので、アルトマンの思想だったりビジョンっていうところを信頼して、それで本当に社会を変えるかもしれないこのLLMの技術を伸ばしていきたいということが、すごく強い思いとして、OpenAIの社内の中にはあるんだなと思っております。

ただ、これのおかげで、今年開発予定であったGPT Storeの開発が来年になるようです。先ほど紹介したGPTsですが、使われるとそのアクセスがこのChatGPTの中に集まるようです。多くの人に使われるくらい便利なGPTsを作ったら、GPT Storeみたいな形でお金を分配をしていくというような構想がありましたがこのゴタゴタがあり、開発スケジュールが変わるというような事態がございました。

Google Gemini: AI業界の多様性を広げる(2023年12月)

最後に、GeminiというものをGoogleが公開したというようなところでで、一番最新のバージョン、ウルトラというものについてはGPT-4を超えるっていう風にGoogle上では言っていおります。

しかし、それも諸説ありまして、例えば、GPTsでBotを作る際に、プロンプトを長く、そして書く技術を使って組んだり、文章を書いています。例えば、一つの文章の一つの文の中に一つの指示しかしないであったり、しないで欲しいという命令であったり、fewshotといって例を挙げるものであったりと様々なテクニックを使ってプロンプトを組むことをします。

このテクニックを使ったプロンプトをゴリゴリに組むことで、GPTの性能は上がるというふうに言われており、ゴリゴリに組んだプロンプトであればGoogleGeminiのUltraにもGPT-4は勝てるっていうような記事があります。

なのでどうやってそれぞれのLLMの性能の比較をするかというのは非常に難しいんですが、プロンプトを組めばGPT-4の方が上だとまだ出ているというような状況です。

2024年の生成AI業界はどうなるか

2024年どうなっていくかっていうところなんですが、企業単位で見ていくとChatGPTの導入っていうのは増えていくかなと思っております。

特に弊社でも開発したTeamsチャットボットを作成するにあたり、RAGという技術を使っております。簡単に説明しますと、社内データをベクトルデータベースの中に入れてGPTがそれを元に回答するというような技術です。このような技術から便利なBotを作ることができ、さらにこのBotがある監査法人様やある通信キャリア様にも導入をいただいているというような状況です。今後も社内対応が自動でできるBotというのがどんどん導入されていき、社内の中で生成AIの活用というのも進んでいくのではと思います。

さらに今後このBotが、Code Interpreterの機能も実装できるようになると、例えば、何かExcelのデータを投げたらExcelの集計可視化グラフの作成をしてくれて、レポートまで書いてくれるであったり、何か議事録を投げたらその議事録を元にどういうことが起こったか議事録を複数枚投げてどういう変遷で意思決定がされてきたかということを抽出してもらうBotとか、様々な機能が一個のBotにどんどん追加されていくいうようになっていくと思います。

そうなると、Teams上やSlack上のボットに聞けば社内のことは何でも教えてくれるし、社内の申請というのも全部やってくれる。誰がどういう発言をしたかというところまで全てそのBotが理解をしている。提案資料も作成してくれるし、Botがないと仕事ができないというような世界に、将来的には(本当に導入が進めばの話にはなりますが、、、)そんな世界になっていくということはあると思います。

なので、2024年でそこまでいけるかというところはわからないんですけども、4年5年ぐらい経ってくると、一つの社内ボットが何でもやってくれる世界も十分にあるのかなと考えております。

以上、2023年の振り返りでした。来年もまたよろしくお願いいたします。